Procesos históricos de individualización e impacto en las esferas privadas compartidas y en la esencia colectiva de la información.

Fabien LechevalierEn esta entrada de blog, Fabien Lechevalier explora las intrincadas dimensiones históricas y contemporáneas de la privacidad.

Manifestantes participan en una protesta en diciembre contra los Juegos Olímpicos y Paralímpicos de París 2024 y el uso de cámaras de vigilancia. Fotografía: Geoffroy van der Hasselt/AFP/Getty Images

La exploración de los procesos históricos en la individualización de la privacidad revela que esta es un concepto complejo y en constante evolución, a menudo interpretado de forma limitada por el derecho. Inicialmente enmarcado como una esfera privada individual, el concepto enfatizaba la discreción y el aislamiento, ejemplificados por la dicotomía entre la esfera privada y la pública. Sociológicamente, la intimidad se manifestó primero en esferas compartidas antes de pasar a las individuales. No fue hasta mediados del siglo XX que la noción de una esfera privada individual adquirió relevancia. Sin embargo, el enfoque legal en la protección de la información privada, basado en una concepción individualista, ha eclipsado el estudio de las esferas privadas compartidas que persisten en la actualidad.

En la era digital, los recientes avances en tecnología de la información enfatizan y transforman la observación de las esferas privadas compartidas. A pesar del proceso de individualización, estas esferas perduran gracias a la naturaleza colectiva de la información . Los individuos existen dentro de redes: familias, amigos y grupos en línea. Además, las tecnologías de procesamiento de la información, en particular el Big Data y los algoritmos, introducen una nueva esfera privada compartida al explotar colectivamente los datos individuales. Esta explotación capitaliza los efectos de red, enriqueciendo mutuamente los datos y generando nueva información muy útil para el sector privado, el sector público y el interés común. Esta función colectiva de la información , acentuada por el procesamiento algorítmico, tiene potencial para la innovación social y económica, impulsando iniciativas en diversos sectores (salud, justicia y, por supuesto, ciudades inteligentes).

Además, considerar la privacidad como un bien colectivo o relacional implica que esta es contextual. El marco de Integridad Contextual (IC) de Nissenbaum conceptualiza la privacidad de la información como normas sociales específicas del contexto, que varían según el entorno y las relaciones . La IC identifica cinco parámetros (sujetos de datos, remitentes, destinatarios, tipos y principios de transmisión) para modelar las normas informativas contextuales.

Si bien la IC ofrece un marco preciso para comprender la privacidad de la información, se enfrenta al reto de determinar las normas contextuales vigentes. Los responsables políticos y los ingenieros, que buscan proteger y respetar la privacidad, deben comprender las expectativas sociales existentes con respecto al flujo de información. La investigación empírica se vuelve crucial para identificar las expectativas sociales, explorando las normas de privacidad en diversos contextos, como la atención médica, la educación y el hogar. Los estudios existentes emplean entrevistas y encuestas para inferir normas sociales a partir de las opiniones, preferencias y actitudes individuales. Sin embargo, este enfoque presenta limitaciones, ya que no proporciona una respuesta directa a la pregunta sobre las expectativas sociales reales. Los investigadores deben ir más allá de las perspectivas individuales y considerar los aspectos colectivos para desarrollar una comprensión más integral de las expectativas sociales con respecto al flujo de información en contextos específicos.

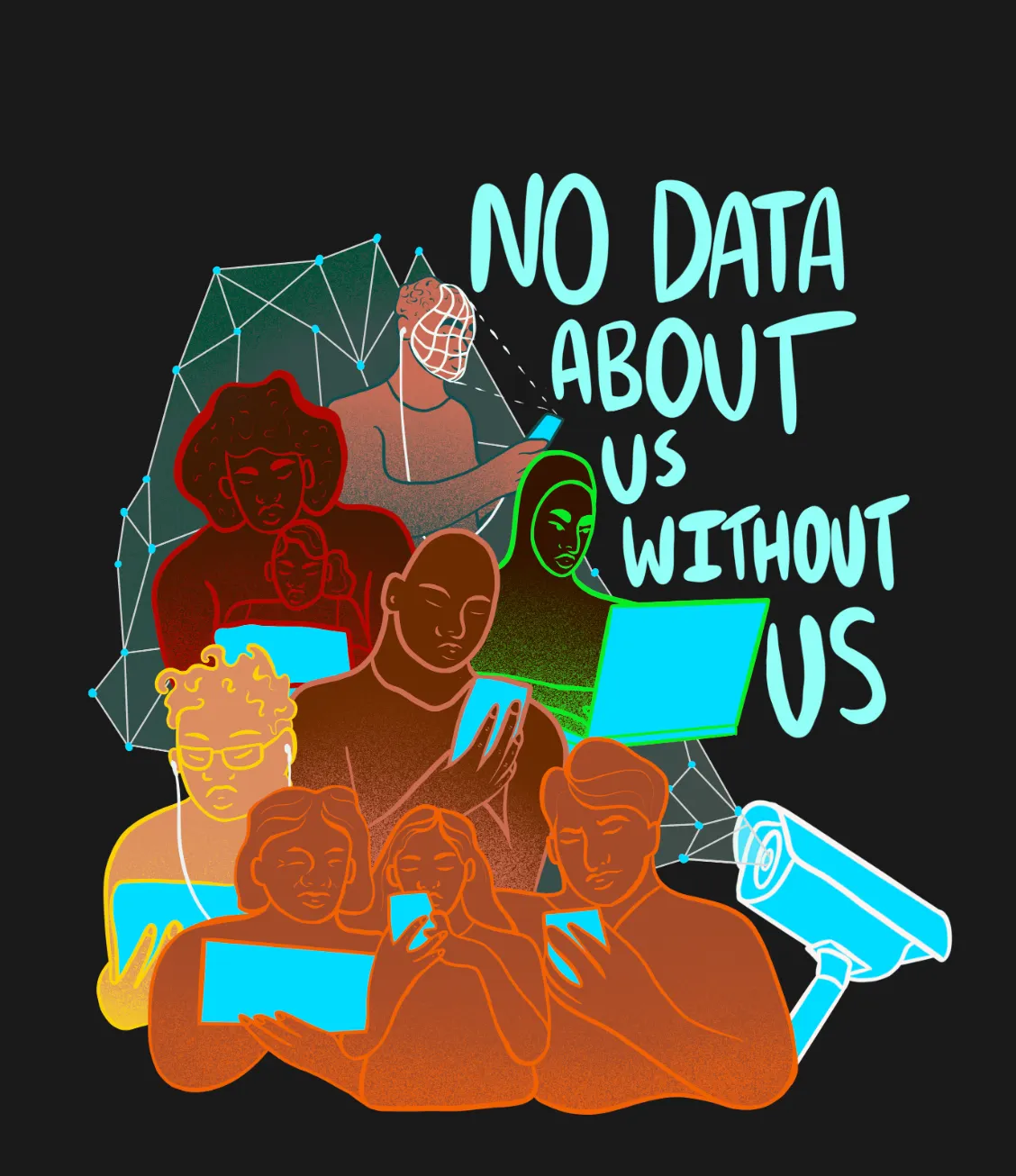

Este proyecto está inspirado en el trabajo de Daniel Susser y Matteo Bonotti sobre los minipúblicos deliberativos de la OCDE para estudiar las normas de integridad contextual , incorporando principios de diseño participativo y codiseño (literatura de diseño legal). Al involucrar activamente a los participantes en todas las fases, el diseño participativo los transforma de sujetos pasivos a contribuyentes activos en un proceso deliberativo colaborativo e inclusivo. El consenso buscado se determina colectivamente y refleja diversas perspectivas. La dimensión de diseño participativo garantiza que los participantes sean cocreadores activos, contribuyendo a una exploración determinada colectivamente de las normas de integridad contextual. Más allá de una metodología aumentada con literatura de investigación sobre estudios de diseño, este trabajo propone como estudio de caso la videovigilancia impulsada por IA durante los Juegos Olímpicos de París 2024. Aborda las preocupaciones sobre las cámaras de videovigilancia algorítmicas y las implicaciones para la privacidad de confiar a las máquinas la identificación autónoma de comportamientos sospechosos. De hecho, en abril, el Parlamento aprobó una ley relacionada con los Juegos Olímpicos que permite el uso de cámaras algorítmicas. Se destacan las preguntas sobre cómo estos sistemas disciernen las amenazas y los problemas más amplios que rodean las libertades individuales. Noémie Levain, responsable de análisis jurídico y político en La Quadrature du Net, señala: «Detrás de esta herramienta se esconde una visión política del espacio público, un deseo de controlar sus actividades». Enfatiza que cualquier herramienta de vigilancia se convierte en una fuente potencial de control y represión tanto para las fuerzas del orden como para el Estado.

Este proyecto comprende tres etapas clave para permitir una comprensión integral de las expectativas sociales respecto del flujo de información en este contexto específico:

3.1 Etapa 1 (Reclutamiento) : Los participantes, representando al público en general, forman foros de aproximadamente 20 parisinos. Seleccionados mediante un muestreo aleatorio estratificado, esto garantiza un grupo diverso e inclusivo, que refleja diversos datos demográficos como edad, género, ubicación en París, contexto cultural, tipo de empleo y entorno familiar. El proceso de reclutamiento es vital para fomentar un ambiente deliberativo donde se representen diversas opiniones.

3.2 Etapa 2 (Expertos e Información) : Los participantes acceden a una amplia gama de conocimientos especializados. Entre los expertos se incluyen profesionales académicos (filósofos, especialistas en ética, politólogos y abogados), representantes municipales (y gubernamentales) (legisladores y funcionarios con experiencia en la formulación de políticas) y representantes del sector (responsables de privacidad/protección de datos o profesionales de la ética que asesoran a empresas tecnológicas en el cumplimiento de las leyes de privacidad).

3.3 Etapa 3 (Deliberación y Facilitación) : Tras las sesiones informativas de los expertos, los participantes participan en un intercambio deliberativo. El objetivo es alcanzar un consenso (definido como un acuerdo del 80 % o más) sobre las normas sociales existentes en materia de privacidad en el contexto específico de la videovigilancia algorítmica. El proceso de deliberación implica evaluar las disrupciones causadas por esta tecnología y determinar las intervenciones o regulaciones necesarias. Facilitadores expertos guían las sesiones, fomentando la escucha activa, la participación empática y el pensamiento crítico. El trabajo en grupos pequeños facilita una deliberación profunda e inclusiva, y se anima a los participantes a reflexionar entre sesiones. El proyecto concluye con un informe compilado de recomendaciones acordadas en colaboración durante el proceso deliberativo.